【英語で読むAI考03】自己意識をもつAIはつくれるか?

前回より引き続き、自己意識をもったAIマシンの話題だ。AI研究者たちは脳の不思議に関して為す術がないようだ。仕方なく「AIもどき」をつくってそれをAIと呼んでいるというのが現状のようである。

意識という言語

THE LANGUAGE OF CONSCIOUSNESS

The reason I suspect that we’ll have AI long before we recognize it as such is that we’ll expect our AI to reside in a single device, self-contained, with one set of algorithms. This is not how we are constructed at all. It’s an illusion created by the one final ingredient in the recipe of human consciousness, which is language. It is language more than any other trait which provides us with the sense that our brains are a single module, a single device.

私は知らぬ間にAIが完成するという見方に与しない。いわゆるAIは、アルゴリズムをワンセット持ち、自己完結型で単体に収まった装置のことだが、人間の知能はそんな風にはできていないからだ。そうした思い違いの原因をつくっているのは、人間の意識を構成する最後の材料だ。そう、言語である。脳が単一のモジュール、単一の装置だと我々に思いこませているのは、他ならぬこの言語なのである。

自己は自己でないものを飼っている

Before I make the argument once again that our brains are not a single entity, let’s consider our bodies, of which the brain is part and parcel.

Our bodies are made up of trillions of disparate cells, many of which can live and be sustained outside of us. Cultures of our bodies can live in laboratories for decades (indefinitely, really. Look up Henrietta Lacks for more). Entire organs can live in other people’s bodies.

And there are more cells within us that are not us than there are cells that make up us. I know that sounds impossible, but more organisms live within our guts, on our skin, and elsewhere, than the total number of cells that are actually our bodies.

These are not just hitchhikers, either. They affect our moods, our health, our thoughts, and our behaviors. They are an essential facet of what we consider our “selves.”

脳は単一の組織体ではない。その議論にふたたび戻る前に、脳もその一部である身体というものについて考えてみよう。

人体は様々な性質を持つ数十兆個の細胞で出来ている。細胞の多くは体外でも生存・持続することが可能だ。身体の培養物なら何十年も実験室で生きることができる(いや永久に、ともいえる。ヘンリエッタ・ラックスのHeLa細胞で調べてみてほしい)。臓器は丸ごと他人の体内で生き続けられる。

我々の体内には、我々をつくりあげている細胞より多くの、我々をつくり上げていない細胞が存在する。ありえないと思うかもしれないが本当だ。我々の臓器や皮膚には、体をつくり上げている細胞より多く、我々ではない生命体が住んでいるのだ。

これらの細胞は単なるヒッチハイカーではない。我々の気分や健康や思考や行動に影響を与えている。我々が「自己」と呼ぶものに不可欠な一部として、ひとつの相を成しているのである。

As horrific as it would be, and it has been for too many unfortunate people, you can live without your arms, legs, and much of your torso. There have been people who have lost half their brains and gone on to live somewhat normal lives. Some are born with only half their brains and manage to get by (and no, you can’t tell these people simply from talking with them, so forget whatever theories you are now forming about your coworkers).

聞くだけでぞっとするが(不幸にも実体験者も多いが)我々は腕や脚や胴体の大半がなくても生きていける。脳の半分を失っても、ほぼ正常と言える生活を送った人もある。先天的に脳が半分しかなくても頑張って暮らしている人も少なくない(彼らと話しただけでは見分けなどつかない。同僚の何某に勝手な理論を適用しようとしている人はいますぐやめよう)。

自分が自分であることの不思議さ

Consider this: By the age of 30, just about every cell that a person was born with has been replaced with a different cell. Almost none of the original cells remain. We still feel like the same person, however.

Understanding all of these biological curiosities, and the way our brains rationalize a sense of “sameness” will be crucial to recognizing AI when it arrives.

It may feel like cheating for us to build a self-driving car, give it all kinds of sensors around a city, create a separate module for guessing vehicular intentions, turn that module back on the machine, and call this AI.

But that’s precisely what we are doing when we consider ourselves “us.” In fact, one of the responses we’ll need to build into our AI car is a vehement disgust when confronted with its disparate and algorithmic self. Denial of our natures is perhaps the most fundamental of our natures.

以下の事実を考えみてほしい。ヒトが生まれたときそのヒトをつくっていた細胞は、30歳までにすべて入れ替わる。オリジナルの細胞はほとんど残らない。それでもそのヒトは自分は自分だと思っている。

こうした興味深い生物学的事実とともに、我々の脳がどのように合理的な「同一性」の意識を作り出しているのか。AIとは何かを認識する上で、こうした事実を認識することは死活的に重要だ。

自走車をつくるとき、自走車の外部で、各種センサーを町中に貼り巡らし、他車の意図を読み取る独立したモジュールをつくる。そして、その独立したモジュールを自走車に組み入れた結果を、我々はAIと呼んでいるのだ。どこか騙されている感じがしないだろうか。

ところが、我々が自分自身のことを「自分」と考えるとき、まさにこれと同じことをしているのである。それだったら、AI車には、アルゴリズムの内部に巣食う異質な自己に直面したとき、強烈な不快感を覚えるような反応機構を組み込んでおく必要があるかもしれない。自分自身の本性に対する否定感情は、おそらく人間の本性のなかで最も基本的な本性だからである。

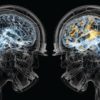

Just like the body, the brain can exist without many of its internal modules. This is how the study of brain functions began, with test subjects who suffered head traumas (like Phineas Gage), or were operated on (like the numerous hemispherectomies, lobotomies, and tumor excisions). The razor-thin specialization of our brain modules never fails to amaze.

There are vision modules that recognize movement and only movement. People who lack this module cannot see objects in motion, and so friends and family seem to materialize here and there out of thin air. There are others who cannot pronounce a written word if that word represents an animal. Words that stand for objects are seen and spoken clearly. The animal-recognition module?as fine a module as that may seem?is gone.

身体同様、脳も内部モジュールが完全に揃っていなくても生きながらえることができる。この事実が起点となって脳機能の研究は始まった。頭蓋骨損傷の患者(フィネアス・ゲージの例が有名)、あるいは大脳半球切除、前頭葉切除、腫瘍切除などの手術を受けた患者が研究対象だった。細分化された脳モジュールの働きにはいつも驚かされる。

視覚モジュールのなかには運動しか認識しないモジュールがある。このモジュールを持たない人間は動きのある物体を見ることができない。したがって友人だろうが家族だろうが、いきなりどこからともなく視野に現れるのだ。動物を表す単語が書かれていると、その単語を発音できない人がいる。ところとがモノを表す単語は見ることも発音することもできるのだ。動物を認識するための脳モジュールというのが存在するのだが、その人にはそのモジュールがないのである。

And yet, these people are self-conscious. They are human.

こうしたすべてにもかかわらず、この人たちは自己意識をもった人間なのである。

So is a child, only a few weeks old, who can’t yet recognize that her hand belongs to her. All along these gradations we find what we call humanity, from birth to the Alzheimer’s patients who have lost access to most of their experiences.

We very rightly treat these people as equally human, but at some point we have to be willing to define consciousness in order to have a target for artificial consciousness. As Kevin Kelly is fond of saying, we keep moving the goalposts when it comes to AI.

Machines do things today that were considered impossible a mere decade ago. As the improvements are made, the mystery is gone, and so we push back the metrics. But machines are already more capable than newborns in almost every measurable way. They are also more capable than bedridden humans on life support in almost every measurable way.

As AI advances, it will squeeze in towards the middle of humanity, passing toddlers and those in the last decades of their lives, until its superiority meets in the middle and keeps expanding.

子どもだって同じだ。自分の手が自分のものだという認識さえままならない生後数週間の赤子でさえ、自意識をもっているのである。新生児の自己に始まって、自分の経験の大部分へのアクセスを失ったアルツハイマー症患者の自己に至るまで、濃淡の差はあっても、それらすべての自己が人間性と呼ばれるものなのだ。

我々は極めて正しくも、これらすべての人々を等しく人間として扱う。しかしどこかの時点で、人工意識の目標を設定するために、意識とは何かをはっきりと定義しなければならない。ケヴィン・ケリーが好んでいうように「ことAIに関しては絶えずゴールポストを移動させ続ける必要がある」のである。

わずか10年前には不可能だと思われていたことを機械はもうすることができる。改良がなされるたびに謎は消滅するから、判定基準をずらす必要が生じる。計測可能な範囲に限定すれば、既に機械は新生児以上のことができる。同じく計測可能な範囲でいえば、生命維持装置につながれた寝たきりの人より機械にできることの方が多い。

AIが進歩していくと、徐々にその能力は、幼児や終焉近い老齢者を追い抜き、人口の中間帯(のもつ能力)へ収斂していく。やがてAIの優越が中間帯を超え、それ以上に拡張し始めるまでは、そうやって推移していくだろう。

This is happening every day. AI has learned to walk, something the earliest and oldest humans can’t do. It can drive with very low failure rates, something almost no human at any age can do. With each layer added, each ability, and more squeezing in on humanity from both ends of the age spectrum, we light up that flickering, buzzing gymnasium.

It’s as gradual as a sunrise on a foggy day. Suddenly, the sun is overhead, but we never noticed it rising.

日々進化は続く。AIは生まれたての赤ん坊にも最晩年の老人にもできない歩行ができるようになっている。どの年齢層の人間もかなわない事故率の低さで運転することができる。機能レイヤーが増えるたび、新たな能力が加わるたび、AIは両端の年齢層から人間性の中央値へ接近していく。

霧深い日の日の出のようにゆっくりとしているように見えるが、あるとき突然、太陽は頭上にある。いつ日が昇ったのが気づく者は誰もいない。

言語の役割って・・・

SO WHAT OF LANGUAGE?

I mentioned above that language is a key ingredient of consciousness. This is a very important concept to carry into work on AI. However many modules our brains consist of, they fight and jostle for our attentive states (the thing our brain is fixated on at any one moment) and our language processing centers (which are so tightly wound with our attentive states as to be nearly one and the same).

先ほど言語は意識の鍵を握る材料だといった。AIの研究を続けるうえでこれは重要な考え方だ。脳を構成するモジュールがいくつあろうとも、各モジュールは我々の注意状態を獲得しようと競い合い(いついかなるときも我々の脳は何かに注意を向けているのだ)、言語処理センターの関与を獲得しようとする(言語処理と注意状態は、まったく同一といえる程度に、密接な関係をもっている)。

As a test of this, try listening to an audiobook or podcast while having a conversation with someone else. Is it even possible? Could years of practice unlock this ability? The nearest thing I know of when it comes to concurrent communication streams are real-time human translators. But this is an illusion, because the concepts?the focus of their awareness?are the same.

It only seems like magic to those of us who are barely literate in our native tongues, much less two or more. Tell me a story in English, and I can repeat it concurrently in English as well. You’ll even find that I’m doing most of the speaking in your silences, which is what translators do so brilliantly well.

試しに、誰かと会話しているときオーディオブックやポッドキャストを聞いてみるといい。そんなことが可能だろうか?何年も練習すれば、できるようになる?同時並行の交信ストリームへの対処という意味では、同時通訳がそれに近いが、それはそう見えるだけだ。認識のフォーカスは一か所に集中しているからだ。

母国が辛うじてでき、他の言語は片言程度しかわからない者には魔法のように映るだけだ。英語で私に話を聞かせてみればいい。私は聞くと同時にいま聞いたばかりの話を繰り返すことができる。その場合、私はあなたが黙っている時間にほとんど話すことになる。通訳者は見事にこれと同じことをしているのである。

言語脳はシリアル処理の出力系

Language and attention are narrow spouts on the inverted funnels of our brains. Thousands of disparate modules are tossing inputs into this funnel. Hormones are pouring in, features of our environment, visual and auditory cues, even hallucinations and incorrect assumptions.

Piles and piles of data that can only be extracted in a single stream. This stream is made single―is limited and constrained―by our attentive systems and language. It is what the monitor provides for the desktop computer. All that parallel processing is made serial in the last moment.

言語と注意は、脳という逆漏斗(※右図のような逆さまにしたジョウゴ)の、先のすぼまった吐水口のようなものだ。何千ものモジュールが、この吐水口目がけてインプットをトスしてくる。トスしてくるのはホルモン、環境情報、視聴覚情報だけではない。ときには幻覚や誤った判断の類までやってくる。

言語と注意は、脳という逆漏斗(※右図のような逆さまにしたジョウゴ)の、先のすぼまった吐水口のようなものだ。何千ものモジュールが、この吐水口目がけてインプットをトスしてくる。トスしてくるのはホルモン、環境情報、視聴覚情報だけではない。ときには幻覚や誤った判断の類までやってくる。

データの束という束は単一の流れにしか抽出されない。注意のシステムと言語は、このような限定と制約のある単一のデータストリームしか出力処理しないように出来ているのだ。その原理はデスクトップ・コンピューターのモニターと同じだ。それまで同時並行で処理されてきた情報は、最終段階で逐次処理に切り替わり、順番に出力されるのだ。

There are terrible consequences to this. I’ve lost count of the number of times I’ve felt like I’m forgetting something only to realize what was nagging at me hours or days later.

I left my laptop in an AirBnB once. Standing at the door, which would lock automatically and irrevocably once I closed it, I wracked my brain for what I felt I was forgetting. It was four in the morning, and I had an early flight to catch. There would be no one to call to let me back in. I ran through the list of the things I might possibly leave behind (chargers, printed tickets), and the things that always reside in my pockets (patting for my wallet and cell phone). Part of me was screaming danger, but the single output stream was going through its paces and coming up empty.

その結果は悲惨なことになる。途中で回数が数え切れなくなって、何か忘れているとずっと感じているのだが、数時間か数日後にならないと、それが何だったか思い出せない状態がずっと続いているのである。

私はAirBnBで予約した宿にラップトップ・パソコンを忘れてきたことがある。一回施錠されてしまえば取り消せない自動ロックドアの前で、何を忘れているのか必死で思い出そうとしていてドアが閉まってしまったのだ。朝の4時で、早朝便に乗らなければならなかった。ドアを開けてもらおうにも誰もいない。充電池とかチケットとか置き忘れそうなもののリストを頭で辿り、次にいつもポケットに入れている財布や携帯を確認する。私の一部分は危険を叫んでいるのだが、なんせ直列式単一流れ処理の脳はマイペースだ。結局、何を忘れたか思い出せない。

組み合わされる動詞の動作を取り消せない、元に戻せない状態を表す便利なことば。この例では「施錠を取り消せない」の意味になる。

wrack one’s brain(=rack one’s brain)

「何かを必死に思い出そうとする」、「知恵を絞る」などの状態を表す。表現的には “rack one’s brain” の方が正しいと言われるが、リンゴ・スターに “Wrack My Brain” という有名な歌があり、”warck” も普通に使われている。発音も意味もほぼ同じ。

The marvelous thing about all of this is that I’m aware of how this happens―that the danger module knows something it can’t get through the funnel of awareness, and so I should pay heed to it. Despite this foreknowledge, I closed the door. Only when it made an audible “click” did the information come through. Now I could clearly see my laptop on the bed where I was making a last-minute note in a manuscript. I’d never left my laptop behind anywhere, so it wasn’t on the list of things to check.

The alarm sounding in my head was part of me, but there’s not a whole me. There’s only what gets through the narrow language corridor. This is why damage to the language centers of our brains are as disastrous to normal living as damage to our memory modules.

この経験が教える素晴らしいところは、私はどうしてそうなったかを認識していた点だ。脳の危険察知モジュールは、認識の漏斗にまだ出力されない何かを知っていた。だから注意を払うべきだったのだ。この前兆的な警告があるのに私はドアを閉めてしまった。ドアを閉めた瞬間、「クリック音」がして私の脳はそれを聞いた。そのとき、警告情報が出力の漏斗を貫通したのだ。ベッドに置きっぱなしにしていたラップトップの映像がありありと脳裏に浮かんだ。あのベッドの上で原稿に最後の手を入れていていたのだった。それまでラップトップを置き忘れたことがなかったから、私の忘れ物リストにラップトップは入っていなかった。

頭の中でアラームを鳴らしていたのは私の一部であって私の全部ではなかった。言語の狭い廊下を通れるものは限られている。だから、言語処理センターの損傷は記憶モジュールの損傷と同じくらい致命的な影響を日常生活に与える。

言語の逐次処理系は理知的判断のための仕組み

I should note here that language is not the spoken word. The deaf process through words as well, as do the blind and mute. But imagine life for animals without words. Drives are surely felt, for food and sex and company. For warmth and shelter and play.

Without language, these drives come from parallel processes. They are narrowed by attentive focus, but not finely serialized into a stream of language. Perseveration on a single concept―my dog thinking “Ball Ball Ball Ball”―would come closest.

注意してほしいのは、ここでいう言語とは話し言葉ではない。聴覚障碍者でも、視覚障碍者でも、言葉が不自由な人でも、言語処理は可能だ。

言葉をもたない動物の生活を想像してみよう。食べ物、セックス、仲間―、彼らは確かにそれらに欲動をもつ。雨露をしのぐ暖、棲み処、そして遊び―、彼らは確かに欲動を感じる。

言語不在の場合、これら動物を駆り立てる欲動は並行処理系から直にやってくる。もちろん注意の焦点は絞られるのだが、言語の流れのなかで厳密に順番通りに処理されないのだ。したがって彼らに最も強く感じられるのは単一の概念だけなのである。私のワンの場合は「ボール、ボール、ボール、ボール」しか感じられないのだ。

We know what this is like from study of the thankfully rare cases where humans reach adulthood free from contact with language. Children locked in rooms into their teens. Children that survive in the wild. It’s difficult to tease apart the abuse of these circumstances to the damage of living without language, except to say that those who lose their language processing modules later in life show behavioral curiosities that we might otherwise assume were due to childhood abuses.

十代をずっと部屋に監禁されていた子ども、野生で生き延びた子どもなど、言語との接触なしに成人した人間(事例が少ないのはホントにいいことだ)の研究からわかることがいくつかある。虐待という複雑な状況の帰結を、言語なしで生きるダメージに帰することはできない。ただ、言語処理モジュールを後天的に失った人間は、幼少期の虐待に起因するとしか思えない奇妙な行動をとることがわかっているのである。

「複雑なAを解きほぐしてBに落とし込む」「複雑なAの原因をBと結論する」という意味。

When Watson won at Jeopardy, what made “him” unique among AIs was the serialized output stream that allowed us to connect with him, to listen to him. We could read his answers on his little blue monitor just as we could read Ken Jennings’ hand-scrawled Final Jeopardy answers. This final burst of output is what made Watson seem human.

It’s the same exchange Alan Turing expected in the test that bears his name (in his case, slips of paper with written exchanges are passed under a door).

Our self-driving AI car will not be fully self-conscious unless we program it to tell us (and itself) the stories it’s concocting about its behaviors.

クイズ番組『ジェパディ』でIBMのワトソンが優勝したとき、「彼」が他のAIと違ってユニークに見えたのは、我々人間が逐次処理の出力ストリームを通じて「彼」の言葉を聞き、「彼」に共感できたからである。ワトソンの小さな青いモニター上のアンサーを、ケン・ジェニングズがハンドスクロールで決めたファイナル・アンサーと同じように読めたからである。この最終段階におけるアウトプットの噴出こそがワトソンを人間らしく見せていたのだ。

チューリングが彼の名を冠したテストで期待した会話のやり取りもこれと同じであった(チューリング・テストの場合、ドアの下から会話の書かれた紙が判定者の前に出される)。

自動運転AIの場合も、自分の行動についてストーリーをでっち上げ、我々に(あるいはAI自身に)語るようにプログラムしなければ、完全に自己意識をもった機械とはいえないだろう。

天才グーグルAI君

This is my only quibble with Kevin Kelly’s pronouncement that AI is already here. I grant that Google’s servers and various interconnected projects should already qualify as a super-intelligent AI. What else can you call something that understands what we ask and has an answer for everything―an answer so trusted that the company’s name has become a verb synonymous for “discovering the answer?”

ケヴィン・ケリーの「AIは既にある」というご宣託に唯一つけたい私のケチはこの点である。グーグルの検索サーバーやその他の相互接続プロジェクトが既に超知的なAIであることは認める。我々の質問を理解し、どんなものにも答えを出してくれる。答えは十分に信用されているから、会社名が「答えを見つける」に等しい意味をもつ動詞までになっている。これをAIといわずして何をAIといえばいいのか。

英語圏でも、”I usually google it when running across a mysterious concept.” などと動詞として使う。日本でも「ググる」と動詞化している。

Google can also draw, translate, beat the best humans at almost every game ever devised, drive cars better than we can, and do stuff that’s still classified and very, very spooky. Google has read and remembers almost every book ever written. It can read those books back to you aloud. It makes mistakes like humans. It is prone to biases (which it has absorbed from both its environment and its mostly male programmers). What it lacks are the two things our machine will have, which are the self-referential loop and the serial output stream.

グーグルのAIは絵も描ければ、翻訳もできる。人間が作ったどんなゲームでも人間より強い。人間よりうまくクルマを運転できるし、他にも、いまだに秘密とされていること、あるいは、とっても怪しげなことができる。グーグルAIは読書もできる。これまでに書かれた本はぜんぶ覚えている。声に出して本を読んでくれる。人間と同じようなミスをする。バイアスに傾きがちだ(きっと製作環境や男の多いプログラマーから吸収したバイアスなんだろう)。あと足りないのは、我々の自己意識AIマシンがもつはずの2つだけだ。ひとつは自己参照ループ、もうひとつは出力の逐次処理系だ。

Our machine will make up stories about what it’s doing. It will be able to relate those stories to others. It will often be wrong.

我々の自己意識AIは自分の行動に関してストーリーをつくり上げる。それを別のストーリーと関連づける。そしてしばしば間違う。

If you want to feel small in the universe, gaze up at the Milky Way from the middle of the Pacific Ocean. If this is not possible, consider that what makes us human is as ignoble as a puppet who has convinced himself he has no strings.

広い宇宙の中で自分のちっぽけさを感じいなら、太平洋の真ん中で天の川を見上げるといい。それが無理なら、人間を人間たらしめている意識なんて、糸なんかないと自分に言い聞かせている操り人形と同じくらい、取るに足らないものだと考えればいい。

もっとましなAIのアイディア

A BETTER IDEA

Building a car with purposeful ignorance is a terrible idea. To give our machine self-consciousness akin to human consciousness, we would have to let it leave that laptop locked in that AirBnB. It would need to run out of juice occasionally. This could easily be programmed by assigning weights to the hundreds of input modules, and artificially limiting the time and processing power granted to the final arbiter of decisions and Theory of Mind stories.Our own brains are built as though the sensors have gigabit resolution, and each input module has teraflops of throughput, but the output is through an old IBM 8088 chip. We won’t recognize AI as being human-like because we’ll never build such limitations.

意図的にアホなAI車をつくるなんて、まともな考え方ではない。人間の意識に似た自己意識を機械に与えたいなら、ラップトップがAirBnB宿に閉じ込められる事態を放置しなければいけないかもしれない。たまに電池切れしてもらわなければダメかもしれない。それは割と簡単にできそうだ。入力モジュールを何百もつくって入力側にウェイトをかけ、脳内の最終意思決定者が、心の論理がつくるストーリーの処理に使える時間や処理能力は、わざとショボくつくればいいのだ。

人間の脳はどんなつくりになっているか。入力側はギガビットの高解像度のセンサーで、テラフロップのスループットを誇る脳モジュール群だ。それに対して出力側はIBM 8000並みの低速チップしか搭載していない。こんな縛りを意図的にAIに課すなんてありえない。もしそうならば、我々が人間らしいと感じるAIは永久につくられかもしれない。

Just such a limitation was built into IBM’s Watson, by dint of the rules of Jeopardy. Jeopardy requires speed. Watson had to quickly determine how sure he was of his answers to know whether or not to buzz in. Timing that buzzer, as it turns out, is the key to winning at Jeopardy.

What made Watson often appear most human wasn’t him getting answers right, but seeing on his display what his second, third, and fourth guesses would have been, with percentages of surety beside each. What really made Watson appear human was when he made goofs, like a final Jeopardy answer in the “American Cities” category where Watson replied with a Canadian city as the question.

『ジェパディ』の場合、この手の制約が番組のルールのお陰でワトソンに課されたのだ。あの番組はスピードを求める。自分のアンサーで早押しするかしないか、ワトソンはとにかく即断しなければならない。早押しのタイミング、これが勝てるかどうかを決める鍵を握っている。

ワトソンがわりとよく人間らしく見えるのは、彼が正解したからではなく、彼の画面に第二、第三、第四のアンサー候補が自信度の数字とともに表示されているからだ。「アメリカの都市」ジャンルのファイナル・アンサーで、カナダの都市名を答えるヘマをしたときこそ、彼は最も人間ぽく見えるのだ。(中略)

Car manufacturers are busy at this very moment building vehicles that we would never call self-conscious. That’s because they are being built too well. Our blueprint is to make a machine ignorant of its motivations while providing a running dialog of those motivations. A much better idea would be to build a machine that knows what other cars are doing. No guessing. And no running dialog at all.

いまも自動車メーカーは、自意識をもっているようには全然見えないクルマづくりにいそしんでいる。彼らのつくるクルマはよく設計され過ぎている。我々の青写真は違う。動機なんかに無頓着な機械、むしろ動機についての会話のログ記録を垂れ流すような機械をつくりたいのだ。もっと人間ぽいクルマをつくりたいなら、他のクルマのことを知っている機械をつくろう。そんなクルマなら推測も、ログ記録もいらなくなる。

That means access to the GPS unit, to the smartphone’s texts, the home computer’s emails. But also access to every other vehicle and all the city’s sensor data. The Nissan tells the Ford that it’s going to the mall. Every car knows what every other car is doing. There are no collisions.

On the freeway, cars with similar destinations clump together, magnetic bumpers linking up, sharing a slipstream and halving the collective energy use of every car. The machines operate in concert. They display all the traits of vehicular omnipotence. They know everything they need to know, and with new data, they change their minds instantly. No bias.

他のクルマのことを知ってるクルマなら、GPSやスマホのテキストや自宅のコンピューターに届いたメールにアクセスできる。他のクルマや町中のセンサー情報にアクセスできる。日産車はフォード車に、モールに行くところだと教える。どのクルマも他のクルマのしていることを知っている。衝突事故は起きない。

高速道路上では、行先の近いクルマが磁気バンパーで連結してつるんで走り、スリップストリームで出来る空気抵抗の薄さを利用しながら、燃費を半分に抑えてエコ走行を行う。マシンは車両の全能さを見せつけながら、協力しながら運転する。知りたいことはぜんぶ知っている。新しいデータが来れば瞬時に気を変える。そこにバイアスはない。(中略)

Imagine for a moment that humans were created by a perfect engineer (many find this easy―some might find such a hypothetical more difficult). The goal of these humans is to coexist, to shape their environment in order to maximize happiness, productivity, creativity, and the storehouse of knowledge.

One useful feature to build here would be mental telepathy, so that every human knew what every other human knew. This might prevent two Italian restaurants from opening within weeks of each other in the same part of town, causing one to go under and waste enormous resources (and lead to a loss of happiness for its proprietor and employees).

This same telepathy might help in relationships, so one partner knows when the other is feeling stuck or down and precisely what is needed in that moment to be of service.

ここでちょっと思考実験だ。我々人間をつくった創造主が、完璧無比なエンジニアだったと仮定しよう(簡単に想像できる人も、そんな仮定はちょっとねという人も)。創造主の作る人間の目的は共存だ。幸福、生産性、創造性、知識のストック、それらすべてを最大化できるよう環境を作りこむ。

ここで役に立つ機能は心のテレパシー機能だ。人間は誰でも他の人間が知っていることを知っている。町の同じ地区に数週以内にイタリアン・レストランが2軒開店するなんて事故は起きない。1軒の経営が立ちいかず多大な資源を無駄にすることもないし、オーナーや従業員の幸福感が失われることもない。

心のテレパシーは人間関係の保善にも役立つだろう。人間はパートナーがにっちもさっちもいかず凹んでいるのを察知して、瞬時にどういう助けが必要かを知ることができる。

It would also be useful for these humans to have perfect knowledge of their own drives, behaviors, and thoughts. Or even to know the likely consequences for every action.

Just as some professional American NFL footballers are being vocal about not letting their children play a sport shown to cause brain damage later in life, these engineered humans would not allow themselves to engage in harmful activities.

Entire industries would collapse. Vegas would empty. Accidental births would trend toward zero.

完璧な創造主に恵まれた人間たちは自分の欲動や行動や思考について完璧に知っている。何らかの行動が引き起こすだろう結果も事前にキャッチできる。

いま一部のNFLアメフトのプロ選手が、後年脳障害を残す可能性の高いこのスポーツを子どもたちにやらせるなと声を大にして訴えている。エンジニア製の人間なら、そんな危険な活動を自分にやらせることはないだろう。

産業はあちこちで壊滅的被害を受けるかもしれない。ラスベガスでは閑古鳥が鳴く。望まれない妊娠は限りなくゼロに近づく。

And this is why we have the system that we do. In a world of telepathic humans, one human who can hide thoughts would have an enormous advantage. Let the others think they are eating their fair share of the elk, but sneak out and take some strips of meat off the salt rack when no one is looking. And then insinuate to Sue that you think Juan did it. Enjoy the extra resources for more calorie-gathering and mate-hunting, and also enjoy the fact that Sue is indebted to you and thinks Juan is a crook.

以上がいまの我々のシステムがいまのようになっている理由なのだ。もしこの世界がテレパシー世界だったら、自分の考えを隠せる人間がとんでもなく有利になる。

他人には十分な鹿肉を食べていると思わせておこう。こっそり抜け出して、誰も見ていない塩漬けの棚から、数本の肉をいただいてしまおう。スーには、それとなくジュアンが犯人じゃないかとほのめかそう。カロリー摂取と相手探しを続けられるだけ余分な資源があることを楽しもう。スーはあなたに借りがあって、ジュアンはとんでもないクズ男だという事実を楽しもう。

This is all terrible behavior, but after several generations, there will be many more copies of this module than Juan’s honesty module.

Pretty soon, there will be lots of these truth-hiding machines moving about, trying to guess what the others are thinking, concealing their own thoughts, getting very good at doing both, and turning these raygun powers onto their own bodies by accident.

ぜんぶひどい行動だけど、数世代後には、ジュアンの正直モジュールの数より、このモジュールの複製の数の方が多くなっているはずだ。

もうじき真実を隠すマシンが動き出す。他人の考えを推測し、自分自身の考えを隠し、どちらも完璧にこなす奴ら。間違って、自分の光線銃パワーを自分自身の体に向けてしまう奴らが、もうすぐ動き出す。

人間の条件

THE HUMAN CONDITION

We celebrate our intellectual and creative products, and we assume artificial intelligences will give us more of both. They already are.Algorithms that learn through iterations (neural networks that employ machine learning) have proven better than us in just about every arena in which we’ve committed resources. Not in just what we think of as computational areas, either.

Algorithms have written classical music that skeptics have judged―in “blind” hearing tests―to be from famous composers. Google built a Go-playing AI that beat the best human Go player in the world. One move in the third game of the match was so unusual, it startled Go experts. The play was described as “creative” and “ingenious.”

我々は人間がつくってきた知的で創造的な製品たちを自画自賛する。人工知能も同じ知性と創造性の勝利だという前提で考えている。たしかにその通りなのだ。

反復によって学習するアルゴリズム(機械学習を採用した神経ネットワーク)は、人間がこれまで投資してきたあらゆる分野で人間より優秀なことが証明されている。いわゆるコンピューター業界にとどまらない。

AI懐疑論者に行った “ブラインド” テストでは、AIの作曲したクラシック音楽が有名作曲家の作品と判定された。グーグルの碁を打つAIは碁の世界チャンピオンを負かした。三戦目でAIが打った一手は碁の専門家を驚かせた。その一手は「創造的」「天才的」と形容されている。

驚くべきAIアルゴリズムたち

Google has another algorithm that can draw what it thinks a cat looks like. Not a cat image copied from elsewhere, but the general “sense” of a cat after learning what millions of actual cats look like. It can do this for thousands of objects.

There are other programs that have mastered classic arcade games without any instruction other than “get a high score.” The controls and rules of the game are not imparted to the algorithm. It tries random actions, and the actions that lead to higher scores become generalized strategies. Mario the plumber eventually jumps over crates and smashes them with hammers like a seasoned human is at the controls. Things are getting very spooky out there in AI-land, but they aren’t getting more human. Nor should they.

グーグルには、これが猫だと思うイメージを絵にするAIもいる。猫の画像をどこからかコピーしてくるのではない。何百万ものリアルな猫の画像データから、これが猫だという「感覚」をつかんで絵にするのだ。このAIは猫に限らず、何千もの主題を同じように絵にできる。

「ハイスコアを叩き出せ」という命令だけで、勝手に古典的なアーケード・ゲームをするプログラムもある。このアルゴリズムには操作ボタンやルールは何一つ教えられていないのである。最初ランダムな動きをするが、高得点を弾き出すアクションがわかるとそれを汎用の戦略に使用する。そしてゲーム達人のように、マリオは華麗に木箱を飛び越してハンマーで木箱をぶっ壊すのである。

AIランドはどんどん怪しげなものに変わっているのは確かだが、人間らしさから遠ざかっている。いや、それでいいのかもしれない。

I do see a potential future where AIs become like humans, and it’s something to be wary of. Not because I buy arguments from experts like Nick Bolstrom and Sam Harris, who ascribe to the Terminator and Matrix view of things (to oversimplify their mostly reasonable concerns). Long before we get to HAL and Cylons, we will have AIs that are designed to thwart other AIs.

Cyberwarfare will enter the next phase, one that it is commencing even as I write this. The week that I began this piece, North Korea fired a missile that exploded seconds after launch. The country’s rate of failure (at the time) was not only higher than average, it had gotten worse over time. This―combined with announcements from the US that it is actively working to sabotage these launches with cyberwarfareーmeans that our programs are already trying to do what the elk-stealer did to Sue and Juan.

人間らしいAIが生まれる未来も予想はできることはできるのだが、そちらはちょっと心配である。『ターミネーター』的『マトリックス』的なAI脅威論者のニック・ボルストロムやサム・ハリスが売っている喧嘩を買いたいからではない(彼らの議論は筋が通っているのだが結論を単純化しすぎのが難点)。HALやサイロンに辿り着くより先に、我々は他のAIを阻止するAIをつくる可能性が高い。

サイバー戦争は、これを書いている瞬間にも第二段階に入ろうとしているようだ。この記事を書き始めたその週に、北朝鮮はミサイルを打ち上げたが発射後数秒で爆発してしまった。かの国の失敗率は(現時点で)平均より高い。しかも失敗率は上昇し続けているのだ。アメリカはサイバー戦争の一環として積極的にミサイル発射の破壊工作を仕掛けていると公表していることを考え合わせると、既にアルゴリズムは、鹿肉泥棒がスーやジュアンにしたのと同じことをしているのではないかと思う。

ここでは「破壊工作をする」という意味の軍事用語。

What happens when an internet router can get its user more bandwidth by knocking rival manufacturer’s routers offline? It wouldn’t even require a devious programmer to make this happen. If the purpose of the machine-learning algorithm built into the router is to maximize bandwidth, it might stumble upon this solution by accident, which it then generalizes across the entire suite of router products. Rival routers will be looking for similar solutions.

We’ll have an electronic version of the Tragedy of the Commons, which is when humans destroy a shared resource because the potential utility to each individual is so great, and the first to act reaps the largest rewards (the last to act gets nothing). In such scenarios, logic often outweighs morality, and good people do terrible things.

インターネットのルーターが、他社製ルーターに忍び込んで帯域幅(通信処理容量)を盗めるようになったらどうだろうか?これには悪意のプログラマーさえ必要ない。ルーターに組み込まれた機械学習アルゴリズムの目的が帯域幅の最大化なのであれば、たまたまこのソリューション(盗み)に行き当たっただけかもしれないが、それは瞬く間に同じ社のルーター製品カタログ全体に波及する。そうなるとライバル社のルーターも同様のソリューションを探すだろう。

これは電子版の共有地の悲劇になってしまう。共有地の悲劇とは、共同資源の効用の大きさに幻惑された個人が抜け駆けで資源を占有し始めると、最初の個人の利益が最大化し、最後の個人の利益はゼロになるという資源の奪い合いで、資源が枯渇する悲劇をいう。そういうシチュエーションでは、理より利が勝つ。本来善良な人々が悪を為すことになる。

「たまたま見つける(出くわす、そうなる)」の意。これも便利な表現。

Cars might “decide” one day that they can save energy and arrive at their destination faster if they don’t let other cars know that the freeway is uncommonly free of congestion that morning. Or worse, they transmit false data about accidents, traffic issues, or speed traps. A hospital dispatches an ambulance, which finds no one to assist.

Unintended consequences such as this are already happening. Wall Street had a famous “flash crash” caused by investment algorithms, and no one understands to this day what happened. Billions of dollars of real wealth were wiped out and regained in short order because of the interplay of rival algorithms that even their owners and creators don’t fully grasp.

いつになく高速が空いている朝、あるAI車が、他のクルマに知らせなければ、自分は省エネもできるし速く目的地に到着できると「決意」する日が来るかもしれない。もっとひどい場合、ウソの事故情報や道路情報、あるいはありもしない速度違反取り締まり情報を他車に流すかもしれない。病院から救急車が送られるが、助けるべき人がいない。

これに類した設計意図に反した結果は既に起きている。ウォールストリートの投資アルゴリズムが「フラッシュクラッシュ」を起こしたが、今日に至るも本当は何が起きたのか誰も知らない。何十億ドルの資産が消え去ったかと思いきや、反対売買のアルゴリズムがすかさず作動、あっという間に資産は元に戻った。しかし反対売買をしたアルゴリズムの所有者も開発者も本当のところは把握できていないという。

Google’s search results are an AI, one of the best in the world. But the more the company uses deep learning, the better these machines get at their jobs, and they arrive at this mastery through self-learned iterations―so even looking at the code won’t reveal how query A is leading to answer B. That’s the world we already live in. It is just going to become more pronounced.

グーグルの検索結果は、世界最高水準のAIが送り返した情報だ。グーグルがディープ・ラーニングを進めれば進めるだけマシンは検索がうまくなり、自己反復学習で熟達の域に達した。もはやコードを眺めて、クエリーAにどうやってアンサーBを返しているのかわからないらしい。

人間は分業と協力の真社会的動物

The human condition is the end result of millions of years of machine-learning algorithms. Written in our DNA, and transmitted via hormones and proteins, they have competed with one another to improve their chances at creating more copies of themselves. One of the more creative survival innovations has been cooperation.

Legendary biologist E.O. Wilson classifies humans as a “Eusocial” animal (along with ants, bees, and termites). This eusociality is marked by division of labor, which leads to specialization, which leads to quantum leaps in productivity, knowledge-gathering, and creativity. It relies heavily on our ability to cooperate in groups, even as we compete and subvert on an individual level.

現在人間の直面している状況は、数百万年にわたる機械学習アルゴリズムの結末である。コードは我々のDNAに書かれている。それはホルモンやタンパク質を介して運ばれ、お互い競い合いながら、自分自身の複製をより多く生み出す確率を高めてきた。生き残りのための創造的イノベーションの中でも、協力という方法は特に優れていた。

伝説的生物学者E.O.ウィルソンは、蟻、蜂、シロアリと並んで人間を「真社会性」動物と定義した。真社会性を特徴づけるのは分業である。分業は専門化を促すとともに、飛躍的に生産性、知識集約、創造性を高める。個人レベルでは競争したり足を引っ張ったりしていても、グループとしては協力する能力がなければ、真社会性は本領を発揮しない。

As mentioned above, there are advantages to not cooperating, which students of game theory know quite well. The algorithm that can lie and get away with it makes more copies, which means more liars in the next generation. The same is true for the machine that can steal. Or the machine that can wipe out its rivals through warfare and other means.

The problem with these efforts is that future progeny will be in competition with each other. This is the recipe not just for more copies, but for more lives filled with strife. As we’ve seen here, these are also lives full of confusion.

Humans make decisions and then lie to themselves about what they are doing. They eat cake while full, succumb to gambling and chemical addictions, stay in abusive relationships, neglect to exercise, and pick up countless other poor habits that are reasoned away with stories as creative as they are untrue.

ゲーム理論の学生ならよく知っているように、協力しないことのメリットは存在する。ウソをついて首尾よく状況を乗り切るアルゴリズムが子孫の増殖にすれば、次の世代はウソつきが増えることになる。戦争その他の手段でライバルを蹴散らすマシンだって増えるかもしれない。

この方向へ精力を傾けると、未来の子孫が(協力する代わりに)お互い競い合うようになることである。自分の複製を増やすだけならいいが、競争漬けになる複製も増えるのだ。既に紹介したように、生命の一部は混乱で満たされているのである。

人間は自分で決断する。だが、その決断がもたらした行動に関しては自分にウソをつく。満腹なのにケーキを食べる。ギャンブルに溺れ、薬物中毒になる。虐待関係を続ける。運動をさぼる。他にも悪習には事欠かない。それは不真実だが、人間はなんとも見事なストーリーで理屈をつけ自分の行動を正当化するのである。

人間の条件を満たすAIはまだ存在しない

The vast majority of the AIs we build will not resemble the human condition. They will be smarter and less eccentric. This will disappoint our hopeful AI researcher with her love of science fiction, but it will benefit and better humanity.

Driving AIs will kill and maim far fewer people, use fewer resources, and free up countless hours of our time. Doctor AIs are already better at spotting cancer in tissue scans. Attorney AIs are better at pre-trial research. There are no difficult games left where humans are competitive with AIs. And life is a game of sorts, one full of treachery and misdeeds, as well as a heaping dose of cooperation.

これまでにつくってきたAIの大半は人間の条件を満たしていない。AIは人間より賢く、穏やかだ。希望に満ちた、SF好きの女性AI研究者をがっかりさせるかもしれないが、人間性の維持と向上には資するだろう。

AI車に殺されたり重傷を負わされたりする人は劇的に減るし、省エネ効果も抜群だ。そのおかげで余暇が増える。細胞組織のスキャンで発癌部位を特定するのは、現在でもドクターAIの方がうまい。弁護士AIは審理前の資料整理がうまい。人間がAIに敵うゲームはほとんどなくなった。人生は裏切りと悪行と、それにもかかわらず協力の束で満たされた一種のゲームだ。

未来

THE FUTURE

We could easily build a self-conscious machine today. It would be very simple at first, but it would grow more complex over time.Just as a human infant first learns that its hand belongs to the rest of itself, that other beings exist with their own brains and thoughts, and eventually that Juan thinks Sue thinks Mary has a crush on Jane, this self-conscious machine would build toward human-like levels of mind-guessing and self-deception.

現在の技術でも自意識をもつAIをつくることは可能だ。自意識AIははじめのうちこそ単純だが、成長するにつれ複雑化していく。

人間の幼児を考えてみよう。最初は自分の手というものが他の自分の一部であることを学び、そのうち、自分の脳や思考は他の人間とともにあることを学び、しまいには「メアリーがジェーンに夢中になってるとスーが思っている」とジュアンが思っていることを学ぶのである。このような自意識AIなら、人間レベルの心の推測能力と自己欺瞞力を身につけていくはずだ。

共存のためのAI

But that shouldn’t be the goal. The goal should be to go in the opposite direction. After millions of years of competing for scarce resources, the human brain’s algorithm now causes more problems than it solves. The goal should not be to build an artificial algorithm that mimics humans, but for humans to learn how to coexist more like our perfectly engineered constructs.

しかしゴールはそこではない。ゴールは反対方向へ行くことだ。数百万年もの間、稀少資源を追い求め競い合った結果、人間の脳は解決する脳であるよりも問題を起こす脳であることが多くなってしまった。人工アルゴリズムの開発目標はこのような人間の模倣であってはならない。完璧なエンジニアが作り出す構造物のように、共存を学ぶ人間のためのアルゴリズムであるべきだ。

Some societies have already experimented along these lines. There was a recent trend in hyper honesty where partners said whatever thing was on their mind, however nasty that thought might be (with some predictable consequences).

Other cultures have attempted to divine the messiness of the human condition and improve upon it with targeted thoughts, meditations, and physical practices. Buddhism and yoga are two examples. Vegetarianism is a further one, where our algorithms start to view entire other classes of algorithms as worthy of respect and protection.

一部の社会ではこの方向で実験が進められている。どんな汚らしい考えでもいいから、とにかく思い浮かんだことをパートナーに言ってもらうハイパー・オネスティなるものが流行っているという(その結果は一部想像がつくが)。

また仏教やヨガの盛んな文化では、人間の状況のだらしなさを心に思い浮かべ、目標とする思考、瞑想、運動などを通じて状況の改善を図るのだという。さらにベジタリアンの運用するアルゴリズムは、他のアルゴリズムの全クラスを、敬意と保護の対象と考えるようになるそうだ。

Even these noble attempts are susceptible to corruption from within. The abuses of Christianity and Islam are well documented, but there have also been sex abuse scandals in the upper echelons of yoga, and terrorism among practicing Buddhists.

There will always be advantages to those willing to break ranks, hide knowledge and motivations from others and themselves, and to do greater evils. Trusting a system to remain pure, whatever its founding tenets, is to lower one’s guard. Just as our digital constructs will require vigilance, so should the algorithms handed down to us by our ancestors.

こうした高尚な試みでも内部崩壊にもろい面があるのは否定できない。キリスト教とイスラム教の誤用については既に大量の記録がなされているが、ヨガの指導層でも性的虐待スキャンダルが起きているし、テロリズムに身を投じる仏教徒もある。

グループ内で規律を破り、本当のことや本当の意図を他のメンバーや自分自身に隠し、悪事を働く者には、それだけのメリットがあるのである。設立趣旨がどうあれ、ある体制がずっと純粋に保たれると信ずれば、警戒心が衰える。デジタル構成物が警戒を要するように、先祖から我々に引き継がれたアルゴリズム(伝統)にも然るべき警戒が必要なのである。

ネガティブな文脈では「somethingに影響されやすい、感染しやすい、(悪影響、感化などを)受けやすい」、ポジティブな文脈では「somethingに敏感な、多感な」

break ranks

「グループ内のメンバーに逆らう」「集団規律を乱す」の意。

人間を模倣する限りAIは自意識をもたない

The future will most certainly see an incredible expansion of the number of and the complexity of AIs. Many will be designed to mimic humans, as they provide helpful information over the phone and through chat bots, and as they attempt to sell us goods and services. Most will be supremely efficient at a single task, even if that task is as complex as driving a car.

Almost none will become self-conscious, because that would make them worse at their jobs. Self-awareness will be useful (where it is in space, how its components are functioning), but the stories we tell ourselves about ourselves, which we learned to generalize after coming up with stories about others, are not something we’re likely to see in the world of automated machines.

将来、数の上でも高度性の面でもAIが爆発的に拡大するのは確実だ。その多くは人間を模倣するAIになるだろう。その方が、電話やチャットボットから有益な情報を取り出したり、モノやサービスを売り込むには便利だからだ。大半のAIは単一の仕事に関しては超効率的になるだろう。仕事の内容が運転のような複雑な作業であっても。

しかしほとんどのAIは自己意識をもたないはずだ。自己意識があると仕事の効率が悪くなるからだ。自己認識はAIにも有益であるはずだ(いまどこにいる?俺の部品はどう動いている?)。でも、我々が脳内で自分に聞かせている自分についてのストーリーは、我々が他人についてのストーリーをつくり上げた後で、もっともらしく一般化するようになったストーリーに過ぎない。そういう自分物語の仕組みは自動化機械の世界には導入されないだろう。

What the future is also likely to hold is an expansion and improvement of our own internal algorithms. We have a long history of bettering our treatment of others. Despite what the local news is trying to sell you, the world is getting safer every day for the vast majority of humanity. Or ethics are improving. Our spheres of empathy are expanding. We are assigning more computing power to our frontal lobes and drowning out baser impulses from our reptilian modules. But this only happens with effort.

We are each the programmers of our own internal algorithms, and improving ourselves is entirely up to us. It starts with understanding how imperfectly we are constructed, learning not to trust the stories we tell ourselves about our own actions, and dedicating ourselves to removing bugs and installing newer features along the way.

我々自身の内なるアルゴリズムの拡張と改良は将来起こりそうだ。人類には、他者の扱いに関して上達してきた長い歴史がある。ローカルの報道がどんな売らんかなの悲惨なニュースを流そうと、人類の大半にとって世界は日々安全な場所になっている。倫理も総体的には向上している。共感の領域は広がっている。人類は、意識的に努力しないとダメだが、爬虫類の基本衝動から前頭葉へより多くの計算能力を割り当てようとしている。

人間は誰しも内なるアルゴリズムのプログラマーだ。自分が向上できるかどうかはひとえに自分次第なのである。向上の第一歩として、人間は不完全につくられていることをまず認識しよう。自分自身の行動について自分に言いかせているストーリーは眉唾だと知ろう。そしてなるべくバグは取り除き、生きていくなかで新しい機能を実装するようにしよう。

While it is certainly possible to do so, we may never build an artificial intelligence that is as human as we are. And yet we may build better humans anyway.

技術的には可能だけれど、結局、人類が人間らしい人工知能をつくることはないのかもしれない。それでも我々自身は今よりましな人間になれるのだ。

<記事引用終わり>

ディスカッション

コメント一覧

まだ、コメントがありません